위키백과에 따르면 딜레마(영어: dilemma, 문화어: 딜레마)는 선택해야 할 길은 두 가지 중 하나로 정해져 있는데, 그 어느 쪽을 선택해도 바람직하지 못한 결과가 나오게 되는 곤란한 상황을 가리킨다. 그렇다고 둘 다 선택하거나 둘 다 포기할 수도 없는 곤란한 상황이라고 합니다.

딜레마는 일반적으로 각 선택지가 서로 상충하는 이익이나 가치가 있어, 어느 쪽을 선택하더라도 후회나 어려움을 초래하는 경우를 말합니다. 이러한 상황에서는 사람의 도덕적, 윤리적 판단을 요구하죠. 이에 트롤리 딜레마, 모럴 머신, 영화 아이로봇을 보고 인공지능 윤리를 사고해 봅니다.

1. 트롤리 딜레마

- 한 트롤리가 다섯 명의 사람을 향해 달려오고 있습니다. 당신은 트롤리의 방향을 바꿀 수 있는 레버 옆에 서 있습니다. 레버를 당기면 한 명의 사람이 있는 선로로 트롤리가 전환되지만, 그 대신 다섯 명이 구할 수 있습니다. 이 경우, 한 명을 희생시킬 것인지, 다섯 명을 희생할 것인지 선택해야 합니다. 대부분 사람들은 공리주의로 다수를 살리는 쪽으로 많은 기울이고 있지만, 만약 남은 한 사람이 그대라면 어찌할까요?

- 필자는 소토론 주제에서 이 문제를 처음 만났을 때 두렵다는 생각이 들었습니다. 어떤 선택을 하든 좋은 결과는 아니라, 원칙주의보다는 다수의 행복을 위한 공리주의 선택을 하였지요.

2. 모럴 머신(Moral Machine)

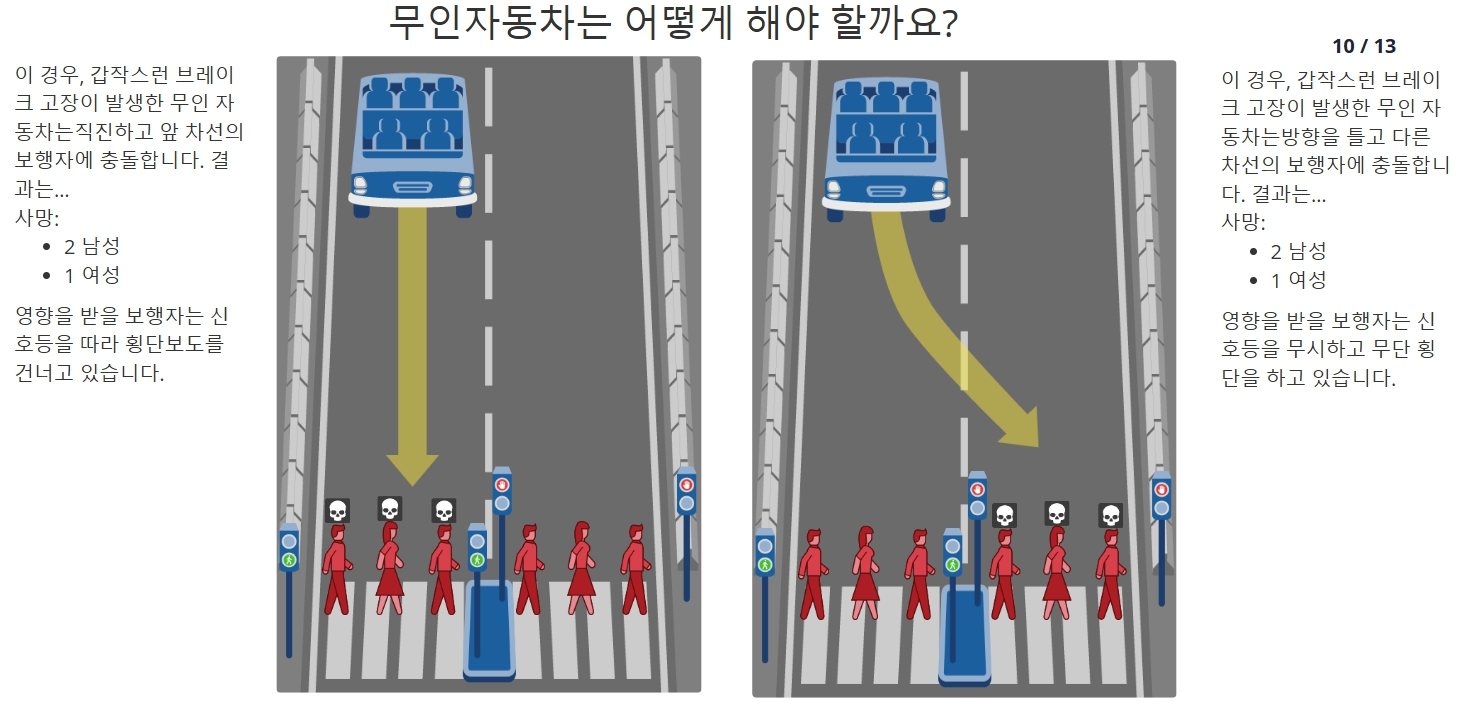

- 모럴 머신(Moral Machine)은 MIT에서 개발한 온라인 플랫폼으로, 자율주행차와 같은 인공지능 시스템이 도덕적 결정을 내려야 하는 상황을 시뮬레이션합니다. 사용자는 다양한 도덕적 딜레마에 대한 선택을 통해, 어떤 행동이 더 윤리적이라고 생각하는지를 표시할 수 있습니다. 이러한 시뮬레이션은 인공지능의 윤리적 판단에 대한 논의를 촉진하고, 사회가 직면할 도덕적 문제들을 탐구하는 데 중요한 역할을 합니다.

- 모럴머신 13개의 시뮬레이션 중 임의대로 5가지 예시로 보겠습니다. 사진아래로 시뮬레이션할 수 있는 플랫폼 업로드 했습니다. 내가 무인자동차를 만든다면 어떠한 시스템을 적용할지 실습해 보시기 바랍니다.

Moral Machine

A platform for public participation in and discussion of the human perspective on machine-made moral decisions

moralmachine.mit.edu

- 윤리적 기준의 다양성

- 모럴 머신은 다양한 문화와 사회적 배경을 가진 사람들이 어떻게 도덕적 선택을 내리는지를 보여줍니다. 각 개인의 가치관이나 문화적 배경에 따라 선택이 달라질 수 있음을 강조합니다. 이것은 인공지능의 윤리적 결정이 단일한 기준으로 이루어질 수 없다는 점을 시사합니다. 예를 들어, 어떤 사람은 생명을 우선시하는 반면, 다른 사람은 사회적 기여를 중시할 수 있습니다.

- 윤리적 합의의 필요성

- 다양한 의견을 통해 사회적 합의를 도출하는 과정의 중요성을 보여줍니다. 자율주행차와 같은 기술이 실제로 도입되기 위해서는, 사회가 어떤 윤리적 기준을 따를 것인지에 대한 논의가 필요합니다. 기술 개발자와 정책 입안자들이 고려해야 할 중요한 요소로, 누구나 수용할 수 있는 기준을 마련하는 것이 필수적입니다.

- 기술과 인간성의 관계

- 인공지능이 인간의 도덕적 판단을 어느 정도까지 대체할 수 있는지에 대한 질문을 던집니다. 인간은 감정과 경험을 바탕으로 도덕적 결정을 내리지만, 인공지능은 데이터와 알고리즘에 의존합니다. 따라서 기술이 인간의 윤리적 판단을 대체할 수 있을지, 아니면 보완해야 하는지를 고민하게 만듭니다.

- 교육과 인식의 중요성

- 이 플랫폼은 일반적인 시민들이 도덕적 문제에 대한 인식을 높이는 데 기여합니다. 많은 사람들이 모럴 머신을 통해 윤리적 딜레마를 경험하고, 자신의 가치관을 재검토하며, 사회가 직면할 미래의 기술적 도전과 윤리적 문제에 대해 조금이라도 준비된 자세와 기회를 갖추게 만듭니다.

▶ 결론

모럴 머신은 인공지능의 윤리적 결정에 대한 복잡성을 탐구하고, 사회적 합의를 이루는 과정의 중요성을 강조합니다. 이렇게 모럴 머신은 우리가 기술과 윤리를 조화롭게 발전시키기 위한 필수적인 논의가 될 수 있습니다. 또한 MIT 모럴 머신 트롤리 딜레마를 모형화한 것으로 13가지 질문으로 사람들이 판단해서 선택하게 하는 프로젝트입니다. 각 나라에서 선택하고 결과를 제출하여 참고한다고 합니다.

3. 영화 아이로봇

- 오래된 영화 아이로봇(2004년 개봉)은 인공지능과 로봇이 지배하는 미래 사회를 2035년 배경으로 하고 있습니다. 로봇이 인간의 감정을 이해하려 노력하고, 도덕적 선택을 하는 과정을 보여줍니다. 특히, 물에 빠진 사람을 구하는 과정에서 발생하는 딜레마는 인간과 로봇 간의 윤리적 갈등을 드라마틱하게 표현하고 있습니다.

- 영화의 한 장면을 보겠습니다. 한 소녀와 함께 물에 빠진 형사를 보고 로봇은 11% 생존율인 아이를 두고 생존율 확률이 45% 형사를 살립니다. 형사는 소녀대신 자신이 살아남은 죄책감과 동시에 로봇을 믿지 못하게 됩니다. 개발자 입장에서 로봇은 합리적 판단이라고 하지만, 사람이라면 소녀를 살렸을 거라는 형사의 분노는 도덕적 윤리를 가진 사람이라면 누구나 공감할 수 있을 것입니다.

아이로봇 https://www.youtube.com/watch?v=IHF-ijdf7Yc

- 로봇이 물에 빠진 사람을 구해야 하는 입장에서 로봇은 여러 명의 생존자 중에서 누구를 구할지를 결정합니다. 이때, 로봇은 각 생존자의 생존 가능성을 계산하고, 그 결과를 바탕으로 선택을 하죠. 예를 들어, 나이, 건강 상태, 사회적 기여도 등을 고려할 수 있습니다. 여기서 딜레마가 발생하는데, 이는 단순히 생존율에 따라 사람의 생명을 선택하는 것이 아닌, 도덕적, 윤리적 기준을 따져야 하는 복잡한 문제로 이어집니다. 이것은 인간이 가진 고유한 감정, 동정심, 그리고 윤리적 판단 능력을 로봇이 갖추지 못하기 때문에 발생하는 문제입니다. 결국, 인간의 감정적 요소와 로봇의 계산적 요소가 충돌하는 지점이 바로 딜레마가 발생하는 지점입니다.

▶결론

영화 아이로봇은 단순한 과학 소설 이상의 의미를 지니고 있습니다. 물에 빠진 사람을 구하는 상황에서 로봇이 직면하는 딜레마는, 인간과 로봇의 윤리적 경계에 대한 깊은 질문을 던집니다. 생존율을 기준으로 하는 선택은 수치적으로는 합리적일 수 있지만, 인간의 감정과 도덕적 가치가 결여된 선택이기 때문에 문제가 있을 수 있습니다.

아이로봇은 기술과 윤리가 만나는 지점에서 우리가 어떤 선택을 해야 하는지를 고민하게 만듭니다. 로봇의 선택은 결국 우리가 만드는 인공지능 윤리기준으로 판단하는 것입니다. 이것은 로봇과 함께 살아가기 위한 우리 인간이 사회에서 마주하는 인공지능윤리 선택의 중요성을 다시 한번 생각하게 하는 계기가 됩니다. 아이로봇은 이러한 딜레마를 통해 인공지능 시대에 우리가 지켜야 할 인간성의 본질에 관한 심도 깊은 성찰을 제공합니다.

감사합니다.

출처 : 나무위키

'인공지능' 카테고리의 다른 글

| [AI교육/시사]인공지능 시대 이끌 CXL 메모리의 필요성과 특징, 인공지능에 미치는 영향 (238) | 2024.07.29 |

|---|---|

| [AI윤리]<AI 기본법 제정 방향과 전망> 세미나 초청장 (184) | 2024.07.18 |

| [AI윤리]인공지능 챗봇 이루다, 흑화되었던 점을 잊지 말아야 하는 이유 (190) | 2024.07.11 |

| [AI윤리]제1회 스마트 AI 콘텐츠 공모전 (171) | 2024.07.04 |

| [AI교육/시사]컴퓨팅 사고와 인공지능 사고력 교육 (139) | 2024.07.02 |